- Die Amazon Deeplens ist bereits seit Ende 2018 in USA erhältlich.

- Seit 10. Juli ist das kleine “KI-Auge” auch in Deutschland verfügbar.

- Amazon positioniert es als Lern-Plattform für Entwickler

Inzwischen ist Amazon’s Smart-Speaker Echo mit der Sprachassistenz-Plattform in der Cloud, Alexa, aus vielen Wohnungen kaum noch weg zu denken. Allein der Gedanke, dass Alexa nicht nur zuhört sondern uns vermeintliche Wünsche per Videoüberwachung von den Lippen ablesen will, spaltet die Technologie-Szene in zwei Lager. Um aus erster Hand herauszufinden was technologisch in der Amazon Deeplens steckt und vor allem was Amazon damit im Schilde führt, sprach Crisp Research pünktlich zur Markteinführung diese Woche mit Constantin Gonzalez, Principal Solutions Architect bei AWS.

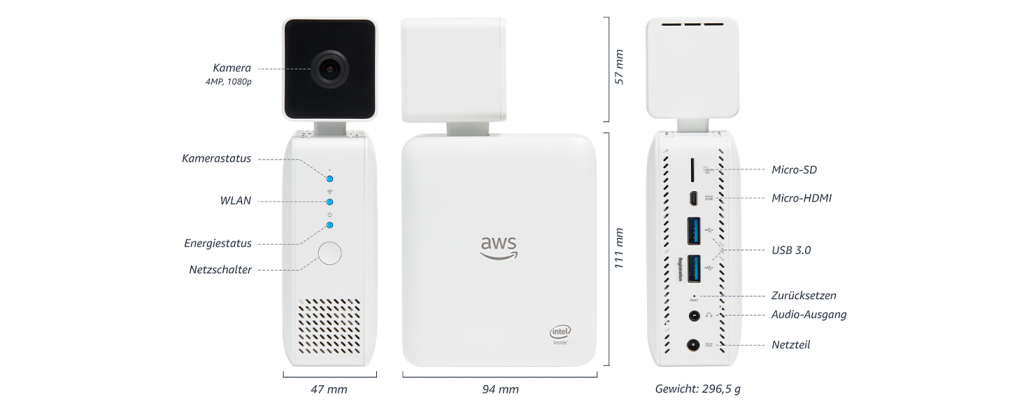

Zunächst zu den Fakten: Die Amazon Deeplens, die jetzt natürlich über den Amazon Onlineshop für €259 verkauft wird, ist eigentlich nichts anderes als ein kleiner Intel Atom Rechner mit 8GB Ram und einer aufgesetzten Kamera. Nachdem die erste Version bereits seit Ende 2018 in USA verfügbar ist, mussten Interessenten fast ein Jahr auf den richtigen Stromstecker und ein CE-Siegel warten, um eine Deeplens in Deutschland kaufen zu können.

Amazon Deeplens – Seit 10. Juli 2019 auch in Deutschland verfügbar

Quelle: Amazon

Die 2019er Version der Deeplens kommt mit einem vorinstallierten Ubuntu OS-16.04 LTS, dass sich der bekannten AWS IoT Edge Komponenten bedient. So läuft lokal das AWS Greengrass Framework, dass hier jedoch nicht dazu benutzt wird beliebige AWS Lambda Funktionen auf die Edge auszuführen. Greengrass ist vielmehr das Deployment Vehicle um “Intelligenz”, die mit viel Rechenpower in der Cloud gelernt wurde, zur Ausführung auf das kleine Edge Device zu bringen. Ein Entwickler verbindet dann gewissermaßen den Video-Stream auf seine Lambda-Funktion, die vorher in der Cloud trainiert wurde. Obwohl Amazon eine Menge vorinstallierter Software Komponenten anbietet, ist das Device vollkommen offen. Entwickler können das Deep-Learning-Framework ihrer Wahl zum Einsatz bringen. Die Amazon-Teams selbst setzen für ihre eigene Entwicklung auf MXNet, da in ihrer Perspective Tensorflow zu stark von Google und Pytorch von Facebook dominiert ist. Zum Apache Deep-Learning Projekt MXNet tragen die unterschiedlichsten Personen von San Francisco bis Shenzhen aus vielen verschiedenen Firmen bei. AWS unterstützt jedoch für seine Kunden alle Frameworks, um diesen eine größtmögliche Flexibilität zu geben. So kommt AWS IoT Greengrass unter anderem auch mit entsprechenden Packages für TensorFlow, MXNet und Chainer und funktioniert mit beliebten Frameworks wie dem Microsoft Cognitive Toolkit oder Caffe2.

Die Programmierbeispiele zeigen natürlich die Kooperation mit anderen AWS Diensten; zum Beispiel wie man Bildanalyse aus Amazon Rekognition oder anderen Trainingsmodellen aus Amazon SageMaker mit der Deeplens auf der “Edge” integriert. Grundsätzlich bleibt die Wahl des Software Stacks aber vollkommen dem Entwickler überlassen.

Diese Offenheit zeigt schon den grundlegenden Unterschied zum Sprach-Pendant. Während Amazons Echo Smart-Speaker-Familie ein fertiges Massenprodukt für den Consumer Markt ist, richtet sich Deeplens zur Zeit wirklich an Software Entwickler. Constantin Gonzalez von Amazon vergleicht es eher mit einem Raspberry. Der bei IoT Entwicklern sehr beliebte Edge-Computer wird in zahllosen Smart-Building oder Industrie-4.0 Prototypen eingesetzt. Zur kommerziellen Anwendung reduzieren aber die meisten Hersteller den Rechner erneut auf die wirklich notwendigen Komponenten und passen die Hardware beispielsweise den industriellen Umweltbedingungen an. Genauso ist auch die Positionierung der neuen Amazon Deeplens. Constantin erwartet, dass hiermit nur Entwickler ihre Anwendungen und fertige Produkte ihre eigene Hardware erstellen, aber den gleichen Software Stack verwenden. Während wir bei Crisp Research dies für die industriellen Anwendungen genauso sehen, können wir uns sehr wohl auch kommerzielle Produkte im Consumer und B2B Umfeld auf Basis der Deeplens Hardware vorstellen, solange es keine erschwerten Umweltbedingungen wie Feuchtigkeit oder Staub gibt.

Unabhängig von der tatsächlich genutzten Hardware ist bei einer Videoanalyse – noch viel mehr als bei einem Sprachassistenz – die Privatsphäre in Deutschland für die Akzeptanz ganz entscheidend. Selbst bei B2B-Anwendungen, bei denen zum Beispiel die Qualität von Produkten in der Fertigung durch optische Kontrolle verbessert wird, ist die Privatsphäre wichtig. Würden mögliche Qualitätsprobleme im Markt bekannt, ist der finanzielle Schade möglicherweise enorm. Hier ist es deshalb eine Überlegung möglichst viel offline bzw. lokal zu machen. Wir haben dies für Sprachsteuerung und Sprach-Assistenten erst kürzlich im Detail in diesen beiden Analyst Views “Hallo IoT” – Warum scheitert die Konversation mit Dingen in der Industrie? und IoT Sprachsteuerung – Das geht auch Offline und sehr Privat untersucht.

Neben dem Ort der Verarbeitung, ist das Bewusstsein des Nutzers, dass seine Sprache oder sein Bild gerade verarbeitet wird, entscheidend für eine Akzeptanz. In dem Zusammenhang hat Amazon im Gespräch mit uns auch noch einmal darauf hingewiesen, dass die Eco-Smart Speaker – entgegen Annahmen im Markt – tatsächlich mit lokaler Rechenleistung auf das Keyword “Alexa” warten und erst dann überhaupt den Audio-Strom in die Cloud weiterleiten.

Analog des Keywords in der Sprache, könnte man bestimmte Gesten oder andere Muster im Video-Strom als Übertragungsindikator vereinbaren. Mit der Deeplens Hardware und dem vorgeschlagenen Software Stack haben Entwickler genau über diesen Teil vollkommene Kontrolle. Bevor hier ein Vertrauen entsteht, sind alle denkbaren Anwendungen fragwürdig. Deshalb ist Deeplens im Moment wirklich als Lern-System für Software-Entwickler positioniert. Haben sie in deutschen Firmen die Skills aufgebaut und das Vertrauen in ihre Programmierung gewonnen, tragen sie dieses Vertrauen ins Unternehmen und stimulieren überhaupt die Video-Deep-Learning Use Cases auf der Business-Seite des Unternehmens.

Zu diesem Zeitpunkt, der in USA eigentlich schon erreicht ist, sollte auch der Gesetzgeber wieder in das Thema einsteigen und mit den renommierten Prüfinstituten wie dem TÜV, die Privatsphären-Funktionalität von fertigen Produkten auditieren können. Crisp Research sieht beispielsweise diese Anwendungen in der Zukunft:

- Healthcare: Unterstützung älterer Personen

Ältere Menschen wollen und könnten in vielen Fällen viel länger in ihrer gewohnten Umgebung und möglicherweise alleine wohnen, als es heute in Deutschland praktiziert wird. Oftmals wird dies aber zu riskant, weil mögliche Unfälle nicht sicher erkannt werden. Natürlich wäre eine konventionelle Video-Überwachung ein inakzeptabler Eingriff in die Privatsphäre. Abgesehen davon wüsste ein Mensch das Bild verfolgen und wiederum manuell einen Alarm auslösen. Ein Deep-Learning Video-System könnte aber vor Ort das Video-Signal verarbeiten ohne dass irgendetwas davon die Wohnung verlässt. Lokal könnten Bewegungsmuster wahrgenommen werden und beispielsweise selbsttätig erkannt werden ob eine Person am Boden liegt oder ungewöhnlich lange im Bett bleibt. - Security Management: Tracking von Personen

Crisp Research sprach in dem Zusammenhang auch kürzlich mit dem deutschen Videoanalyse-Pionier Dieter Jöcker, heute CTO bei Bosch Security Systems. Was in der lokalen Rechenleistung einer professionellen Überwachungskamera trotzdem kleinem Energiebedarf möglich ist, zeigt dieser Film von Bosch. Während der deutsche Technologiekonzern solche fertigen Lösungen verkauft, legt es Amazon darauf an möglichst viele Entwickler aus allem möglichen Branchen zu erreichen. - Industrie 4.0: Qualitäts Management

Optische Qualitätssicherung in der Industrie ist überhaupt nicht neu. Schon lange kann beispielsweise die Lackierung von Autos oder bestimmte Prozessschritte in der Halbleiter-Fertigung mit Video-Methoden optimiert werden. Der entscheidende Unterschied liegt aber heute in dem Reifegrad der Lernmethoden. Dienste wie Amazon Rekognition oder SageMaker sind neu im Vergleich zur industriellen Innovationsgeschwindigkeit (Rekognition wurde auf der re:Invent 2017 vorgestellt). Damit lassen sich neue Qualitätskriterien innerhalb kürzester Zeit erlernen anstelle sie explizit zu codieren. - Authentifikation von Personen: Video als zweiter Faktor

Im Consumer-Umfeld, wie beispielsweise beim iPhone X, wird eine Gesichtserkennung zur Nutzer-Authentifikation verwendet. Im professionellen Umfeld sollte man sich jedoch nie auf einen Faktor verlassen. Beispielsweise kann der Zugang zu einem Raum, der heute nur durch einen RFID geschützt ist, bald schon mit sehr wenig Aufwand durch eine Deep-Learning basierte Video-Verarbeitung ergänzt werden. - Research und Ausbildung: Deep-Learning zum Anfassen.

Schon heute findet ein wesentlicher Teil der AI Grundlagenforschung in China statt. Nur kann hierzulande keiner wissenschaftliche Veröffentlichungen auf chinesisch lesen. Damit Studenten eine Chance haben die Grundlagen und Methoden effizient und schneller zu erlernen hat Amazon das Deepracer-Spielzeug auf dem Markt gebracht. Das kleine Modell-Auto ist eigentlich nichts anders als eine Deeplens auf Rädern (mit noch etwas Motion-Control und Sensorik). Genauso wie die Deeplens ist der Deeprazer wahrscheinlich niemals als autonomes Fahrzeug in öffentlichen Gebäuden unterwegs. Er hilft aber hoffentlich der kommenden Generation Ingenieuren und Informatikern der deutschen Autobranche aus der Patsche und das autonome Fahren zum Mainstream werden zu lassen.

Deeplens auf Rädern – Amazon Deepracer

Quelle: Amazon

Zusammenfassend kann Crisp Research zum heutigen Zeitpunkt deutschen Unternehmen dringend empfehlen mit Deep-Learning Technologie für Video-Streams zu experimentieren und die passenden Use-Cases und digitalen Produkte ihrer Branche zu diskutieren. Dabei ist es vollkommen egal, mit welcher Hardware oder mit welchem Software Stack man dies macht. Amazon, Google und Microsoft liefern sich hier einen enormen Innovations-Wettstreit. Eine “normierte” Hardware wie Amazons Deeplens macht das Prototyping sicher schneller, es geht aber auch mit einem handelsüblichen Intel NUC und einer USB Kamera. Schafft ein Hersteller jedoch die Transformation von einer Prototyping Plattform zu einer kommerziell ausgereiften Hardware, locken große Marktanteile und eine treue Entwicklergemeinde. Microsoft hat dies dem Markt mit der Hololens bereits gezeigt. Nach ihrer Markteinführung im März 2016 und vielen Software Iterationen, sowie drei Jahren weiterer Hardwareentwicklung ist eine präferierte Augmented Reality Plattform im Markt entstanden. Microsoft integriert diese entsprechend mit seinen Deep-Learning Services auf Azure. Das Wettrennen der Hyperscaler bleibt also weiterhin spannend.